Hai semuanya, apa kabar? Kali ini saya mau lanjutin nulis tentang Ceph. Ada beberapa tulisan saya tentang Ceph beberapa waktu lalu, seperti tulisan pada link ini. Pada tulisan ini saya akan coba untuk konfigurasi Ceph dari awal, supaya teman-teman yang masih belum paham bisa sama-sama belajar bareng hehehe.

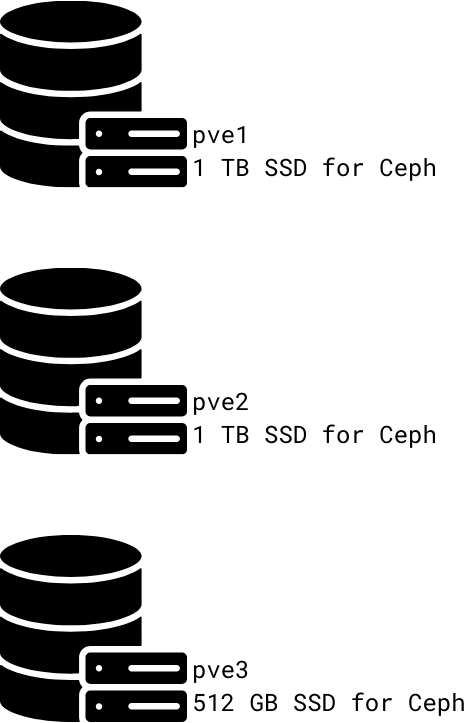

Disk yang akan saya gunakan sebagai OSD atau penyimpanan pada Ceph adalah seperti pada gambar 1:

gambar 1

Tiga node Proxmox VE. Dua node memiliki disk (untuk OSD) sebesar 1 TB dan satu node lagi memiliki disk sebesar 512 GB.

Untuk instalasi Ceph kita memerlukan minimal tiga disk. Data akan disebar ke seluruh disk yang ada pada cluster. Jadi, kalau kita punya 3x 1 TB disk kapasitas penyimpanannya bukan menjadi 3 TB, namun tetap 1 TB karena data direplikasi pada seluruh disk.

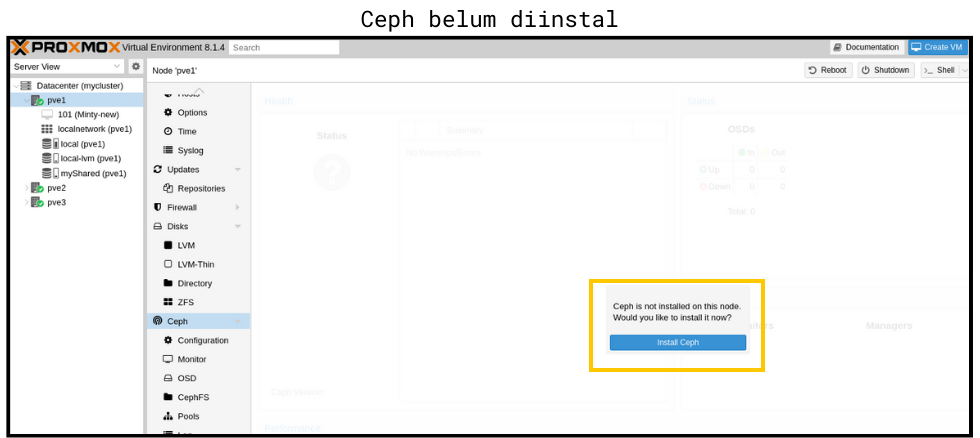

Lanjut konfigurasi. Pada node Proxmox VE, pilih menu Ceph. Apabila Ceph belum diinstal, maka tampilannya seperti pada gambar 2 berikut. Kita pilih tombol Install Ceph untuk melanjutkan proses instalasi Ceph. Untuk pengujian kali ini saya melakukannya pada node pve1.

gambar 2

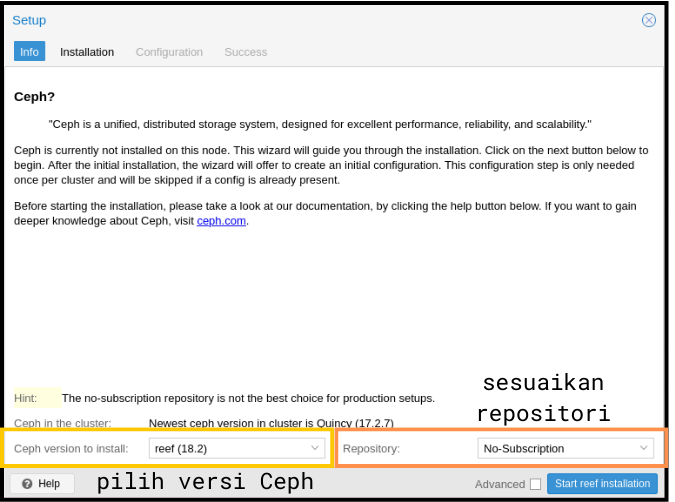

Setelah memilih tombol Install Ceph akan muncul jendela konfigurasinya seperti pada gambar 3. Untuk pengujian kali ini saya pilih versi yang terbaru (reef-18.2). Apabila kita tidak punya/tidak berlangganan PVE subscription, maka pilih repositori No-Subscription, karena secara default Ceph akan mengarahkan ke Enterprise repository. Pilih tombol Start reef installation (reef karna versi yang dipilih pada pengujian ini adalah reef) untuk melanjutkan proses instalasi Ceph.

gambar 3

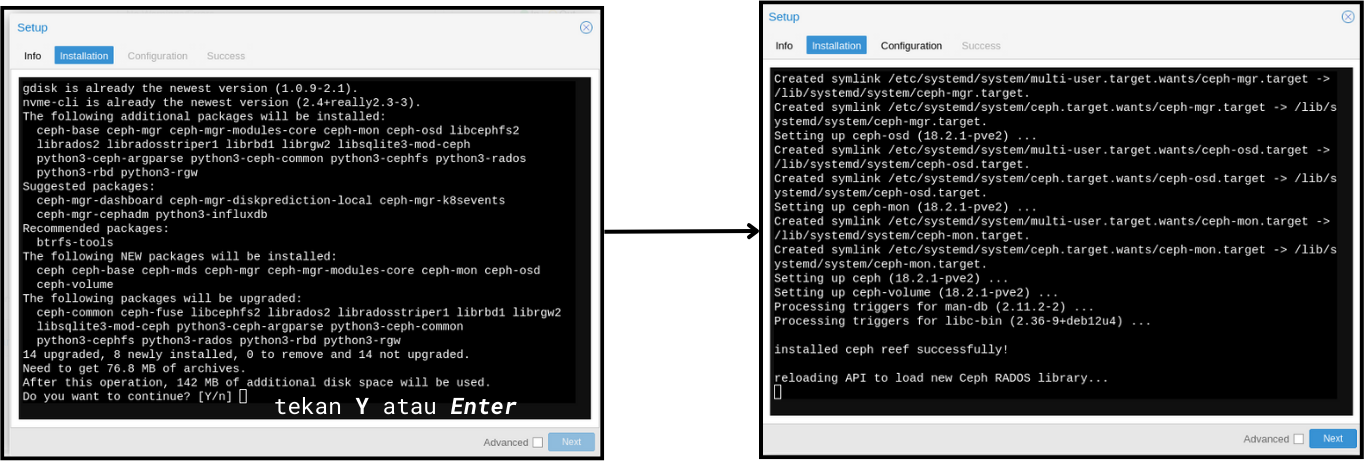

Selanjutnya akan berjalan proses untuk instalasi Ceph seperti pada gambar 4. Kita perlu memilih Y/Enter seperti instalasi program/service di Linux pada umumnya. Setelah selesai seperti gambar 4 bagian kanan (terdapat tulisan “installed ceph successfully”), kita bisa melanjutkan ke tahap selanjutnya, yaitu Config. tab.

gambar 4

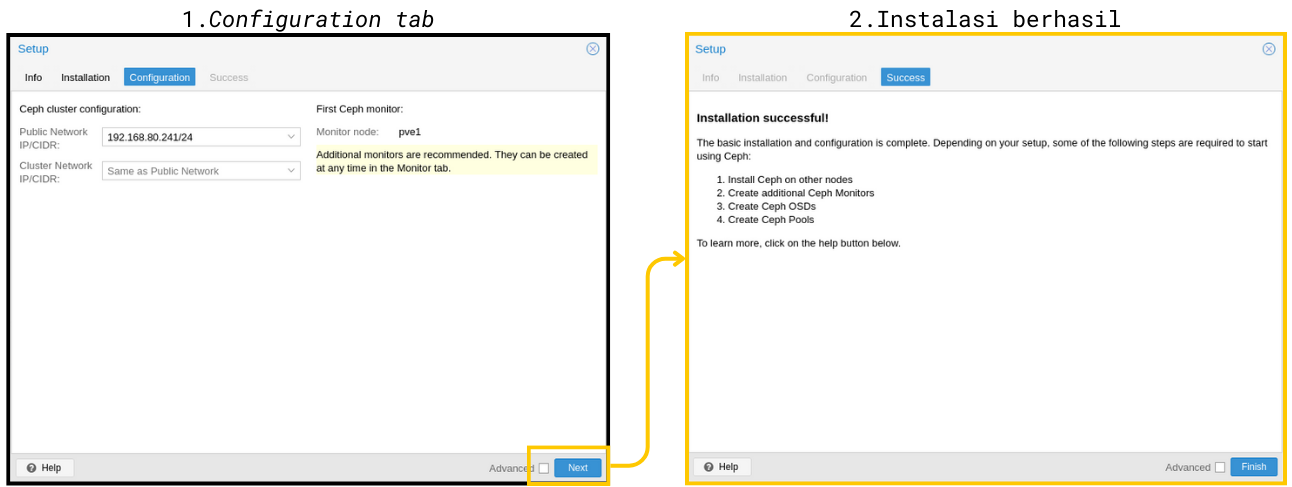

Pada Configuration tab (gambar 5-1), kita diminta untuk memasukkan alamat IP untuk Ceph cluster. Pada parameter Public Network saya pilih IP yang tersedia (pada gambar 5 merupakan IP dari pve1) dan pada parameter Cluster Network tidak saya ubah (default). Selanjutnya pilih tombol Next untuk melanjutkan, dan pada gambar 5-2 menampilkan pesan bahwa instalasi Ceph sudah berhasil (pada node terpilih; pve1).

gambar 5

Selanjutnya kita perlu melakukan instalasi Ceph pada node lain (in my case, pve2 & pve3). Caranya sama seperti sebelumnya, namun pada Config tab kita tidak perlu memilih IP lagi karena sudah “ikut” konfigurasi node sebelumnya (kita lihat gambar 6).

gambar 6

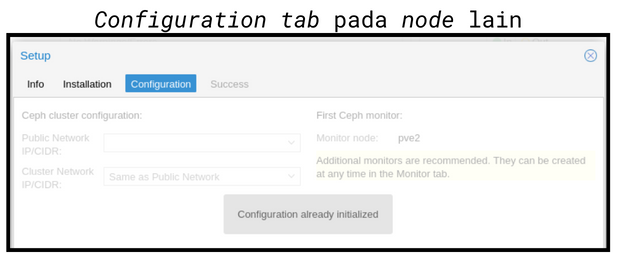

Apabila semua node sudah dipasang Ceph, selanjutnya kita perlu melakukan konfigurasi untuk Ceph Monitor. Ceph Monitor dapat diibaratkan sebagai agen yang bertugas untuk memantau kondisi Ceph cluster. Untuk kinerja yang optimal, Ceph Monitor minimal ada tiga buah.

Pada pengujian kali ini kita buat Ceph Monitor terlebih dahulu. Dimulai dari pve1 (dapat dilihat pada gambar 7). Menambahkan node lain seperti pve2 dan pve3 sebagai Ceph Monitor juga bisa dilakukan dari interface pve1 (pilih node > Ceph > Monitor). Pilih tombol Create untuk menambahkan Ceph Monitor baru.

gambar 7

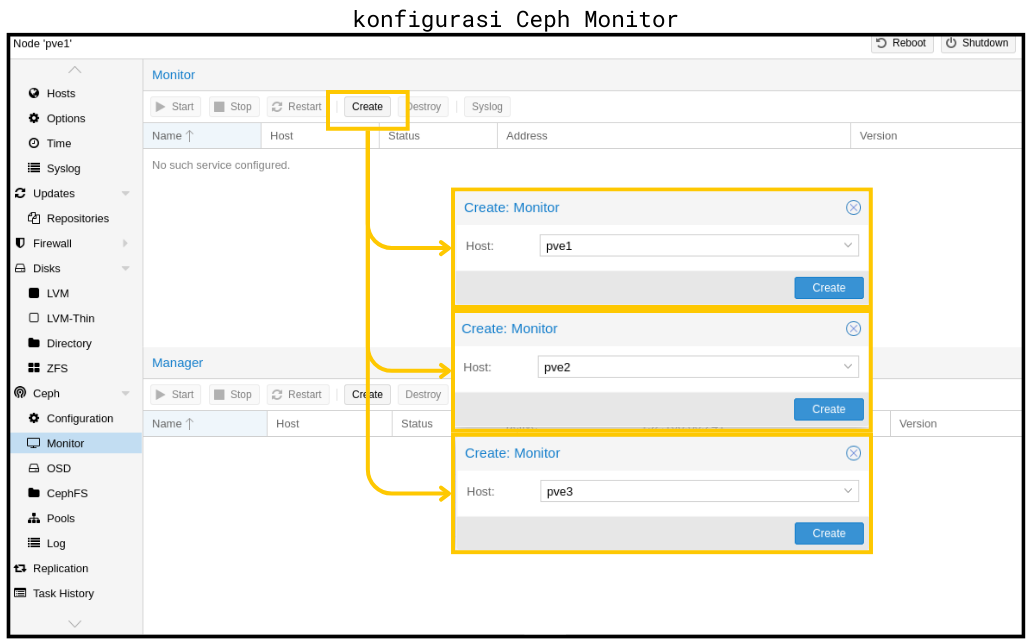

Setelah selesai, kita cek kembali apakah Ceph Monitor sudah berhasil ditambahkan atau belum. Gambar 8 menampilkan bahwa konfigurasi Ceph Monitor sudah berhasil dibuat. Selanjutnya adalah konfigurasi Ceph Manager. Ceph Manager secara kasar dapat diartikan sebagai agen yang melakukan kendali atau kontrol terhadap Ceph cluster.

gambar 8

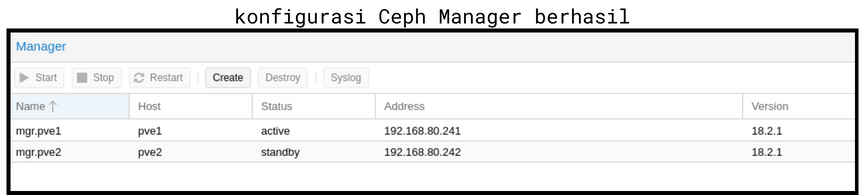

Untuk konfigurasi Ceph Manager, minimal diperlukan dua buah. Pada pengujian kali ini saya menunjuk pve1 dan pve2 sebagai Ceph Manager. Masih dalam halaman yang sama dengan Ceph Monitor (pilih node > Ceph > Monitor) kita bisa tekan tombol Create untuk menambahkan Manager baru. Gambar 9 menampilkan konfigurasi Ceph Manager berhasil.

gambar 9

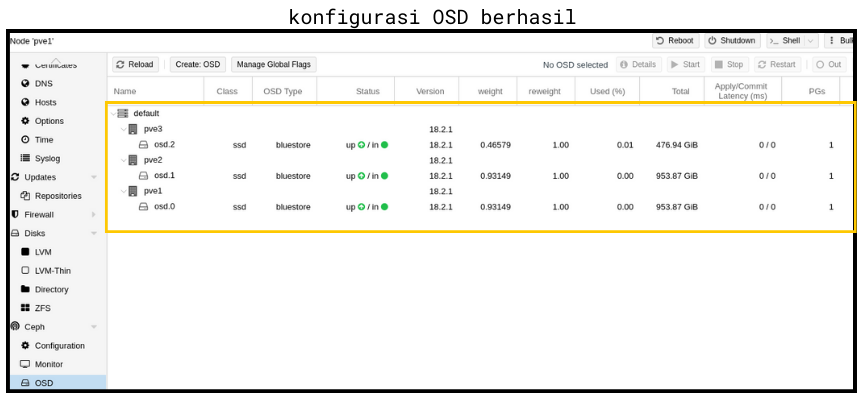

Konfigurasi Ceph Monitor dan Manager sudah selesai, sekarang saatnya konfigurasi OSD (Object Storage Daemon) atau media penyimpanan yang akan digunakan. Kalau konfigurasi sebelumnya (Monitor&Manager) bisa dilakukan (konfigurasi/menunya) dari node mana saja, untuk OSD kita perlu atur dari tiap node.

Menu OSD ini terletak dibawah menu Monitor. Gambar 10 menampilkan halaman OSD pada node pve1 masih kosong. Untuk konfigurasi OSD baru, pilih tombol Create OSD. Kemudian pilih disk yang akan dijadikan sebagai penyimpanan. Oiya, disk yang saya pakai pada pve1 dan pve2 baru dan tidak perlu diformat terlebih dahulu. Jadi kalau teman-teman punya disk baru untuk di-Ceph-kan, gausah bingung. Gausah diformat terlebih dahulu juga bisa dipakai.

gambar 10

Selanjutnya, lakukan hal yang serupa pada node-node lain. Lalu kita cek kembali apakah OSD sudah berhasil dikonfigurasi pada tiap node dengan melihat pada menu OSD. Apabila berhasil, maka OSD yang sudah dikonfigurasi akan muncul pada menu OSD seperti pada gambar 11.

gambar 11

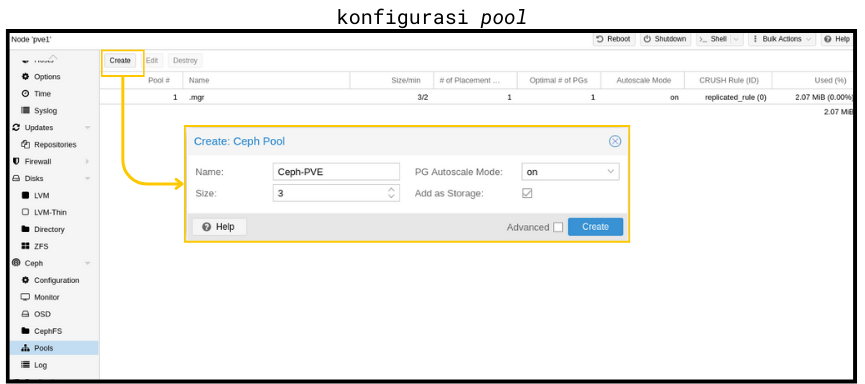

Apakah sudah selesai semuanya? Belum dong hehehe. Ada konfigurasi lain yang perlu dilakukan. Yaitu Pool. Kita perlu membuat pool baru yang isinya (tiga) OSD yang baru saja kita buat tadi. Kita tambahkan/buat pool baru dengan menekan tombol Create (kita lihat pada gambar 12. Sudah ada pool lain yaitu .mgr).

gambar 12

Beri nama pada pool yang akan dibuat (parameter Name). Parameter Size artinya adalah jumlah replikasi yang akan dilakukan. Apabila konfigurasi berhasil, maka pool baru akan muncul pada halaman Pool.

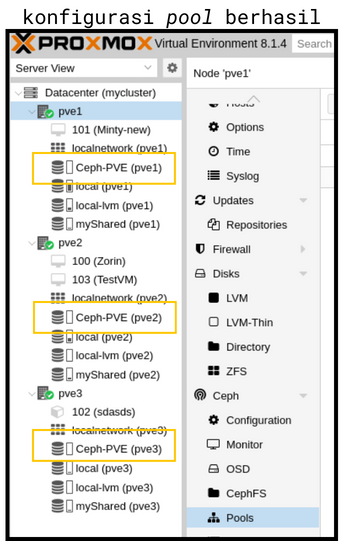

Selanjutnya kita cek panel kiri. Pada gambar 13 kita bisa lihat bahwa semua node sudah terhubung ke penyimpanan Ceph (Ceph-PVE pool). Artinya konfigurasi yang kita lakukan berhasil

gambar 13

Nah untuk tulisan kali ini segini dulu yaa. Next time kita coba buat VM dan VM storage-nya kita taruh di Ceph-PVE. Kayanya menarik. Sampai jumpa, bye~